12 Prompting Techniken für bessere Ergebnisse in der Arbeit mit LLMs

- Zero Shot Prompting

- One / Few-Shot Prompting

- Chain-of-Thought Prompting

- Step-Back Prompting

- Self Consistency Prompting

- Instruction Tuning Prompting

- Role-Based Prompting

- Retrieval Argumented Generation (RAG) Prompting

- ReAct (Reasoning + Acting) Prompting

- Reflexion Prompting

- Automatic Prompt Engineering (APE)

- Wenn Du Hilfe brauchst …

Zu einem guten Prompt Engineering zählen auch die Kenntnis und das Verständnis unterschiedlicher Prompting Techniken und Strategien. Ich erkläre dir zwölf unterschiedliche Prompting Techniken, mit denen Du deine Effektivität, Effizienz und Qualität in der Arbeit mit KI-Systemen deutlich steigern wirst.

Zero-Shot Prompting

Bei dieser Prompting Technik erhält die KI nur eine direkte Anfrage, ohne ergänzende Beispiele oder weiterführenden Kontext. Der Vorteil des Zero-Shot Prompting ist die schnelle und einfache Anwendung. Der größte Nachteil ist sicherlich, dass Du mit den Antworten nicht wirklich arbeiten kannst.

📌 Beispiel: „Erkläre Blockchain.“

✅ Vorteil: Schnell und einfach.

❌ Nachteil: Unpräzise und unspezifisch, potentiell unbrauchbar.

One / Few-Shot Prompting

Beim One / Few-Shot Prompting bekommt die KI ein (One Shot) oder mehrere Beispiele, um den gewünschten Antwortstil oder die Struktur zu lernen. Der größte Nachteil des Few-Shot Prompting ist sicherlich, dass Du vorab eigenen Gehirnschmalz in die ersten Beispiele investierst. Dafür profitierst Du dann von konsistenten Antworten. Das Few-Shot Prompting lohnt sich vor allem dann, wenn Du eine große Zahl wiederkehrender Aufgaben hast.

📌 Beispiel: Erkläre Begriffe wie in diesen Beispielen: KI ist wie ein Gehirn, Cloud ist wie ein unsichtbarer Speicher. Erkläre in dieser Art die Blockchain.

✅ Vorteil: Konsistente und gezieltere Antworten.

❌ Nachteil: Erfordert mehr Vorarbeit im Prompting.

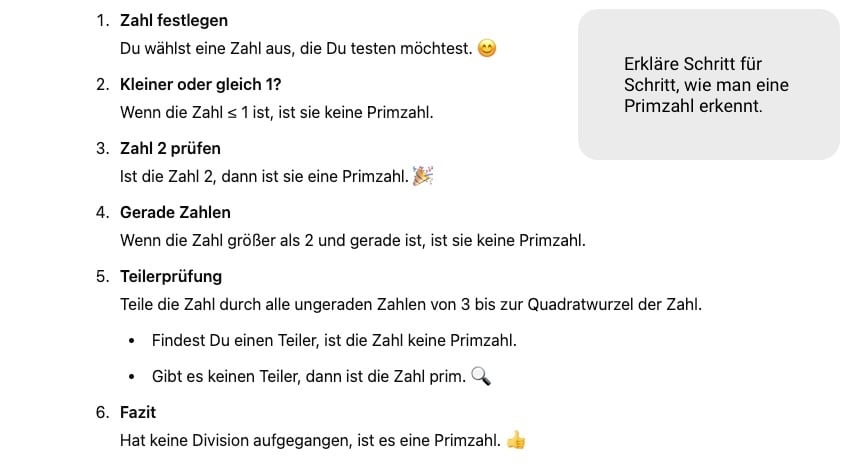

Chain-of-Thought Prompting

Beim Chain-of-Thought Prompting forderst Du die KI auf, Lösungen schrittweise zu präsentieren. Diese Art des Prompting ist vor allem dann sinnvoll, wenn Du einen genauen Ablauf und ein “How To” als Antwort erwartest.

📌 Beispiel: Erkläre Schritt für Schritt, wie man eine Primzahl erkennt.

✅ Vorteil: Genauer Ablauf für komplexe Aufgaben.

❌ Nachteil: Kann zu langen und sehr detaillierten Antworten führen.

Um den potentiellen Nachteil auszugleichen, kannst Du das Chain-of-Thought einfach mit dem Few-Shot Prompting kombinieren und deinem Assistenzsystem direkt ein paar Beispiele mitgeben, in welchem Umfang Du einzelne Bearbeitungsschritte erhalten möchtest.

Step-Back Prompting

Beim Step-Back-Prompting wird die KI zunächst dazu aufgefordert, eine allgemeine Frage zum Thema zu betrachten, bevor sie die spezifische Aufgabe bearbeitet.

📌 Beispiel: Anstatt direkt "Warum ist meine Website langsam?" zu fragen, fragst Du zunächst "Was sind die Hauptfaktoren für eine gute Website-Performance?" und dann "Meine E-Commerce-Site lädt 8 Sekunden - was könnte das Problem sein?"

✅ Vorteil: Reduziert Verzerrungen, aktiviert tieferes Wissen, führt zu durchdachteren und genaueren Antworten.

❌ Nachteil: Benötigt zusätzliche Schritte und kann bei einfachen Aufgaben unnötig komplex sein.

Das Step-Back-Prompting kannst DU auch als eine besondere Form des Chain-of-Thought Prompting verstehen. Dabei aktivierst Du mit deinem Prompt relevantes Hintergrundwissen und Denkprozesse, wodurch die KI fundierte und durchdachte Antworten generiert. Dadurch kann die KI kritischer denken und ihr Wissen kreativer anwenden.

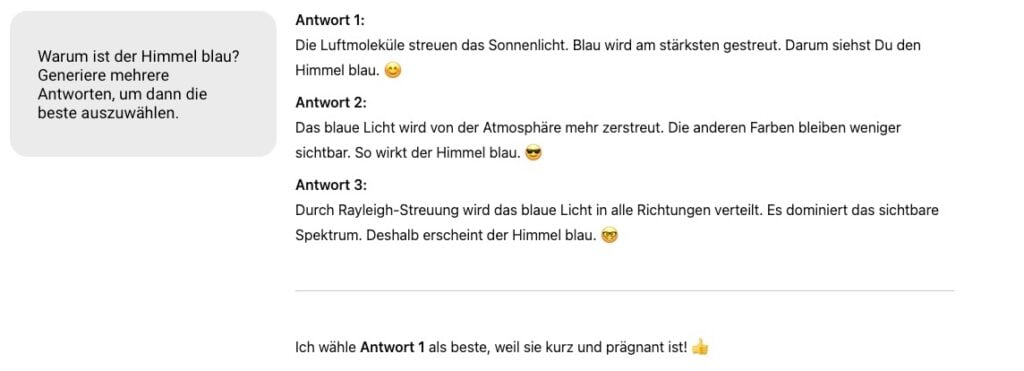

Self-Consistency Prompting

Beim Self-Consistency Prompting bereitet das Large Language Modell mehrere Antworten vor, um eigenständig die beste Antwort vorzuschlagen. Der größte Vorteil ist sicherlich, dass Du mehrere Erklärungsmodelle auf dem Silbertablett serviert bekommst. Ein möglicher Nachteil ist, dass Du das Denken einstellst und die beste Antwort einfach übernimmst.

📌 Beispiel: Warum ist der Himmel blau? Generiere mehrere Antworten, um dann die beste auszuwählen.

✅ Vorteil: Auswahl mehrerer Antwortmöglichkeiten

❌ Nachteil: Erfordert theoretische mehr Rechenleistung und Bearbeitungszeit.

Tree of Thoughts (ToT) Prompting

Die Tree of Thoughts Prompting Technik erweitert das Chain of Thought Prompting, indem es LLMs ermöglicht, mehrere Denkpfade gleichzeitig zu erkunden statt nur einer linearen Gedankenkette zu folgen. Das Modell erstellt einen "Gedankenbaum" mit verschiedenen Lösungsansätzen und bewertet jeden Pfad systematisch.

📌 Beispiel: "Plane eine 3-tägige Reise nach Berlin mit 500 Euro Budget. Erstelle 3 verschiedene Konzepte: 1) Kultur-fokussiert, 2) Food-fokussiert, 3) Nachtleben-fokussiert. Bewerte jeden Ansatz nach Kosten und Machbarkeit, dann wähle den besten aus."

✅ Vorteil: Führt zu durchdachteren, kreativeren Lösungen durch systematische Exploration verschiedener Optionen.

❌ Nachteil: Benötigt deutlich mehr Rechenzeit und komplexere Prompts als einfaches Chain of Thought.

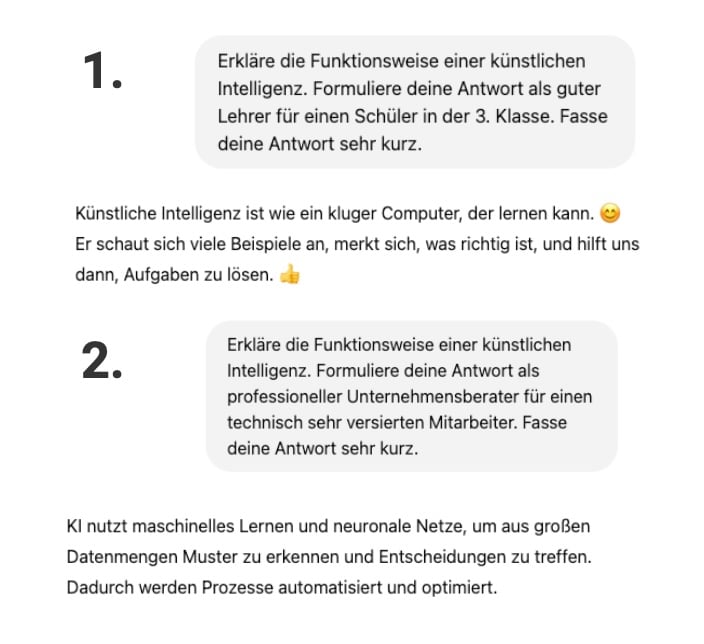

Instruction-Tuning Prompting

Bei der Prompting Technik gibst Du dem KI-Assistenten präzise Anweisungen, um Antworten in einem bestimmten Stil oder Format zu geben. Das heißt, mit dem Instruction-Tuning Prompting spezifizierst Du vor allem in Bezug auf den Stil der Antworten des Assistenten. Das Instruction-Tuning Prompting ist also ein elementarer Eckpfeiler des Prompt Engineering.

📌 Beispiel: Antworte in einem professionellen Ton und verwende maximal drei Sätze.

✅ Vorteil: Hohe Kontrolle über Ton, Länge und Stil der Antwort.

❌ Nachteil: Funktioniert nur, wenn das Modell gut auf die Art der Anweisungen trainiert ist.

Role-Based Prompting

Beim Role- oder auch Persona Based Prompting forderst Du KI-Modelle auf eine bestimmte Rolle anzunehmen. Der Vorteil dieser Prompting Technik ist, dass Du Interaktionen deutlich authentischer gestalten kannst. Die Gefahr jedoch, dass das KI-Modell ggf viel Kontext braucht, um diese Rolle auch seriös auszufüllen.

📌 Beispiel: Du bist ein erfahrener Arzt, erkläre einem Patienten, was Bluthochdruck bedeutet.

✅ Vorteil: Realistische und kontextbezogene Antworten.

❌ Nachteil: Kann zu subjektiven oder voreingenommenen Antworten führen.

Role based Prompting am Beispiel Crew.ai

Im Agenten-Framework Crew.ai kannst Du beim Aufsetzen eines KI-Agenten folgende Attribute verwenden. Das ist ein guter Anhaltspunkt, den Du in die Definition einer Rolle alles einfließen lassen kannst.

- Role - Definiert die Funktion und Expertise des Agenten

- Goal - Das individuelle Ziel, das die Entscheidungen des Agenten leitet

- Backstory - Kontext und Persönlichkeit für reichere Interaktionen

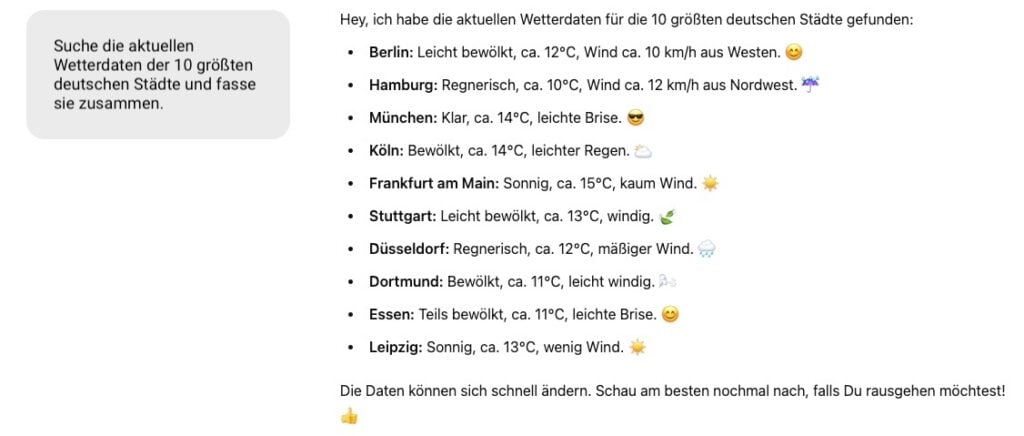

Retrieval-Augmented Generation (RAG) Prompting

Retrieval-Augmented Generation (RAG) ist eine der wichtigsten Techniken. Bei dieser Prompting Technik kombinieren Large Language Modelle internes Wissen mit externen Datenquellen, um aktuellere und genauere Antworten zu liefern. Das RAG Prompting setzt natürlich voraus, dass Du Zugriff auf externe Datenquellen hast oder deinem KI-Agenten diesen Zugriff gewähren kannst.

📌 Beispiel: Suche die aktuellen Wetterdaten der 10 größten deutschen Städte und fasse sie zusammen.

✅ Vorteil: Ideal für dynamische Aufgaben mit externen Datenquellen.

❌ Nachteil: Funktioniert nur mit Zugriff auf verlässliche Datenquellen.

ReAct (Reasoning + Acting) Prompting

Beim ReAct Prompting lässt Du KI-Systeme erst nachdenken (Reasoning), um dann zu handeln (Acting). Das “Acting” setzt voraus, dass das LLM auch Zugang zu externen Tools hat. Ohne Tools, kein "Acting”, kein ReAct, dann bist Du eher in der Domäne anderer Prompting Strategien (z.B. Chain-of-Thought, Step-Back Prompting). Die Fähigkeit zur eigenständigen Problemlösung mit externen Tools macht ReAct zu einem wichtigen Baustein für autonome KI-Agenten.

📌 Beispiel: "Ordne meine E-Mails nach Wichtigkeit."

🧠ReAct-Prozess:

- Gedanke: Ich schaue mir erst die E-Mails an, um Kategorien zu erkennen

- Handlung: [E-Mail-Postfach analysieren]

- Beobachtung: Sehe 50 E-Mails - Meetings, Rechnungen, Newsletter, Kundenanfragen

- Gedanke: Kundenanfragen sind am dringendsten, dann Meetings für heute

- Handlung: [Erstelle Kategorie "Urgent" für Kundenanfragen]

- Beobachtung: 5 Kundenanfragen markiert

- Gedanke: Jetzt die heutigen Termine priorisieren

- Handlung: [Sortiere Meeting-E-Mails nach heutigem Datum]

- Ergebnis: E-Mails in 3 Prioritätsstufen sortiert: Urgent, Heute, Später

✅ Vorteil: Löst komplexe Organisationsaufgaben durch schrittweise Analyse und Anpassung der Strategie.

❌ Nachteil: Benötigt Tool-Zugriff, kann zeitaufwändig und teuer werden.

Dabei kann ReAct Prompting natürlich auch RAG nutzen (z.B.: Rufe das Wetter von Berlin, Hamburg, München ab, entscheide, wo ich hinfahre und was ich einpacken muss). Das prägnante Merkmal der ReAct Prompting Technik ist jedoch das iterative Denken-Handeln-Prinzip. Auch unabhängig davon, ob externe Daten abgerufen werden.

📌 Beispiel: "Entscheide, wo ich hinfahren soll und was ich einpacken muss."

🧠 ReAct-Prozess mit RAG:

- Gedanke: Ich brauche Wetterdaten für alle drei Städte

- Handlung: [RAG: Wetter Berlin, Hamburg, München abrufen]

- Beobachtung: Berlin 15°C/Regen, Hamburg 12°C/bewölkt, München 22°C/sonnig

- Gedanke: München hat das beste Wetter, dort fahre ich hin

- Handlung: [Entscheidung treffen: München]

- Gedanke: Bei 22°C und Sonne brauche ich Sommerkleidung

- Handlung: [Packliste erstellen basierend auf Wetter]

- Ergebnis: Fahre nach München, packe T-Shirts, Shorts, Sonnenbrille

Beim ReAct Prompting forderst Du LLM also auf, iterativ über eine Aufgabe oder ein Problem nachzudenken, um dann eine konkrete Handlung auszuführen.

Reflexion-Prompting

Das sogenannte Reflexion-Prompting bedeutet, dass Du ein Large Language Modell aufforderst, ihre eigenen Antworten zu bewerten, Schwächen zu erkennen und Alternativen zu erwägen. Auf Basis der Einschätzung kannst Du dann deine Prompts weiter ausrichten. Man könnte vereinfacht sagen, dass das Reflexion Prompting eine Variante des ReAct Prompting ist mit einem “Human in the Loop”.

📌 Beispiel: Erkläre mir Value-Based Pricing. (siehe Beispiel).

✅ Vorteil: Mehrstufige, flexible Herangehensweise mit “Human in the Loop”.

❌ Nachteil: Längere Bearbeitungszeit, ggf differenzierte Prompts.

| User | Erkläre mir Value-Based Pricing. |

| Assistant | Value-Based Pricing bedeutet, dass der Preis eines Produkts auf dem wahrgenommenen Wert für den Kunden basiert. |

| User - Reflexion | Bewerte deine Antwort: Ist sie detailliert genug? Gibt es konkrete Beispiele? |

| Assistant - Reflexion | Die Antwort ist korrekt, aber zu allgemein. Ein Beispiel fehlt. |

| User | Verbessere deine Antwort mit einem Beispiel und einem Praxisbezug. |

| Assistant | Value-Based Pricing bedeutet, dass der Preis eines Produkts auf dem wahrgenommenen Wert für den Kunden basiert. Beispiel: Apple setzt hohe Preise für iPhones an, weil die Marke einen starken emotionalen Wert für Nutzer hat. |

Automatic Prompt Engineering (APE)

Automatic Prompt Engineering ist eine Meta-Technik, bei der Du ein LLM nutzt, um bessere Prompts zu erstellen. Das heißt, Du lässt Prompts schreiben, um diese dann in ein LLM zu übergeben. Lass uns das Automatic Prompt Engineering (APE) an einem einfachen Beispiel anschauen

📌 Prompt: “Ich will einen Text ins Deutsche übersetzen. Vor allem ist mir wichtig, dass ich englische Wörter, die eingebürgert sind, beibehalte. Schreibe mir dazu einen Prompt.”

🧠 Antwort: Übersetze den folgenden Text ins Deutsche. Behalte dabei englische Wörter bei, die im deutschen Sprachgebrauch etabliert und gebräuchlich sind (wie "Meeting", "Team", "E-Mail", "Marketing", "Business", "Laptop", "Software", "Online", "Update", "Download", etc.). Übersetze nur Wörter ins Deutsche, die im deutschen Alltag unüblich oder fremd klingen würden.

Das LLM formuliert mir einen Prompt und wendet dabei eine automatisch bewährte Prompting Technik an. In unserem einfachen Beispiel das One / Few-Shot Prompting (Beispiele als Teil des Prompts) und Instruction-Tuning Prompting (Klare Anweisungen "Behalte bei...", "Übersetze nur...").

Hier ist ein weiterführendes Automated Prompting Beispiel, dabei lässt Du das LLM unterschiedliche Prompts generieren, um ein Chatbot zu trainieren.

📌 Beispiel: Schreibe einen Prompt für einen Kundenservice-Chatbot, der E-Mail-Reklamationen bearbeitet. Der Bot soll empathisch, lösungsorientiert und professionell antworten. Wichtig ist auch, dass verschiedene Reklamationstypen (defekte Ware, verspätete Lieferung, falsche Bestellung) unterschiedlich behandelt werden.

🧠 Antwort: Du bist ein erfahrener Kundenservice-Spezialist mit 10 Jahren Erfahrung (Role-Based).

Analysiere zunächst den Reklamations-Typ, bevor du antwortest (Step-Back).

Folge diesem strukturierten Vorgehen (Chain-of-Thought): 1. Erkenne die Art der Reklamation 2. Zeige Empathie und Verständnis 3. Biete konkrete Lösungen an 4. Überrasche mit zusätzlichem Service

Beispiele für verschiedene Typen (Few-Shot): Defekte Ware: "Entschuldigung + Ursachenanalyse + Ersatz + Gutschein" Verspätung: "Entschuldigung + Tracking-Info + Expressversand" Falschlieferung: "Entschuldigung + Abholung + Erneute Lieferung + Bonus"

Antworte professionell, aber menschlich. Vermeide Standardfloskeln.

Abschließende Tips & Best Practices

Bevor Du dich jedoch in diesen Prompting Techniken verlierst, hier nochmal wesentliche “best practices” für ein gutes Prompting:

- Beispiele: Wann immer Du kannst, gib der KI eigene Beispiele.

- Keep it Simple: Baue deine Prompts so einfach wie möglich auf, zusätzliche Instruktionen nur wo es wirklich notwendig ist.

- Spezifiziere den Output: formuliere klare Erwartungen an den Output. Wenn Du eine Tabelle willst, dann spezifiziere wie sich Zeilen und Spalten zueinander verhalten sollen und dass Du das Ergebnis in ein gSheet kopieren willst.

- Instruktionen statt Einschränkungen: Explizite Anweisungen zum gewünschten Format, Stil oder Inhalt der Antwort sind besser als Einschränkungen, was das Modell nicht tun oder vermeiden soll.

- Struktur: Gerade bei längeren Prompts, achte auf eine gute und “human readable” Struktur für eine dauerhafte Optimierung.

Für die Anwendung in skalierten Umgebungen ist es außerdem noch wichtig, die Kosten respektive den Umfang des Outputs über spezifische Instruktionen zu steuern. Zudem empfiehlt sich dann auch der Einsatz von Variablen.

Fazit - Prompting ist wie Fahrrad fahren

Der Fantasie sind beim Prompting keine Grenzen gesetzt. Die unterschiedlichen Prompting Techniken bieten dir ein grundlegendes Rüstzeug, diesen wichtigen Skill weiter zu schärfen. Dabei würde ich nach dem ShuHaRi Prinzip vorgehen: Mit den hier vorgestellten Prompting Techniken anfangen, nachmachen, Ergebnisse bewerten und Prompts verfeinern. Wenn das sitzt, dann beginnen einzelne Prompting Techniken miteinander zu kombinieren. Das ist dann wie beim Fahrrad fahren: irgendwann fährst Du freihändig auf dem Hinterrad. Alles eine Frage der Übung.

Viel Erfolg dabei.

Andreas Diehl

Vom Kenner zum Könner

Als Gründer der dno stehe ich dir für dein Anliegen zur praktischen Anwendung gerne persönlich zur Verfügung.

1:1 Coaching

Ich nehmen mir Zeit deine Fragen zu beantworten. Schnell, einfach, unkompliziert auch ohne Beratungsmandat.

Vorträge & Schulungen

Wir präsentieren und erklären das Thema live auf deinem Event in internen Mitarbeitern Lunch & Learns oder Schulungen.

Anfrage sendenBeratung & Workshops

Sofern Du weiterführende Unterstützung benötigst, stell dir einen unverbindlichen Strategiecall ein, um dein Anliegen zu besprechen.

Anfrage sendenWeiterführende Beiträge

Was suchst Du?

- Zero Shot Prompting

- One / Few-Shot Prompting

- Chain-of-Thought Prompting

- Step-Back Prompting

- Self Consistency Prompting

- Instruction Tuning Prompting

- Role-Based Prompting

- Retrieval Argumented Generation (RAG) Prompting

- ReAct (Reasoning + Acting) Prompting

- Reflexion Prompting

- Automatic Prompt Engineering (APE)

- Wenn Du Hilfe brauchst …